Wochenende ist Podcast- und Lesezeit. Beim Hören des Podcasts „Tech, KI und Schmetterlinge“ ist mir neben zwei prominent zum Ende hin genannten Erkenntnissen eine offensichtliche Lücke im ersten der berühmten, von Asimov schon 1942 sehr weitblickend erdachten, Robotergesetze aufgefallen.

Die beiden Erkenntnisse aus dem Podcast will ich hier nicht unterschlagen.

- Die, ebenfalls weitblickende, Idee von Sascha Lobo, dass wir so etwas wie Roboter-Apartheid denken können. Wenn man an eine Zukunft mit vielen humanoiden Robotern, die uns im Alltag begleiten, glaubt, wäre es vielleicht eine gute Idee, getrennte Bereiche für Menschen und Roboter zu definieren (ohne die negative Konnotation des Apartheid-Begriffes). Also abgetrennte Bereiche in öffentlichen Verkehrsmitteln, „Roboterwege“ ähnlich Fahrradwegen usw.

- Dass es mindestens eine Alternative zu irrsinnigen Visionen eines Herrn E.M. (seines Zeichens Tesla-, Raketen-, Satelliten und sonstwas-Bauers) gibt, der in naher Zukunft 10 Milliarden humanoide Robots zu einem Preis zwischen 20.000 und 25.000 Dollar als Ersatz für die Autoindustrie sieht. Bedenkt man den Ressourcenverbrauch dieser üblich rücksichtslosen Tech-Vision, ist das wohl eher eine Ansage für eine dystopische Zukunft als ein positiver Ausblick. Die Alternative ist shared economy. Nicht jeder besitzt einen oder gar mehrere Roboter. Stattdessen werden Roboter ihrem Zweck entsprechend zur Erledigung bestimmter Aufgaben gemietet. Einerseits minimiert das den Bedarf an zu bauenden Robotern (immer noch genug) andererseits könnte das den zeitlichen Punkt der konkreten Einsatzfähigkeit nach vorne ziehen. Der einzelne Roboter muss nicht sämtliche Fähigkeiten besitzen, die im Haushalt anfallen. Spezialisiertere Roboter kommen ins Haus, erledigen ihre Aufgabe und begeben sich dann zum nächsten Einsatzort.

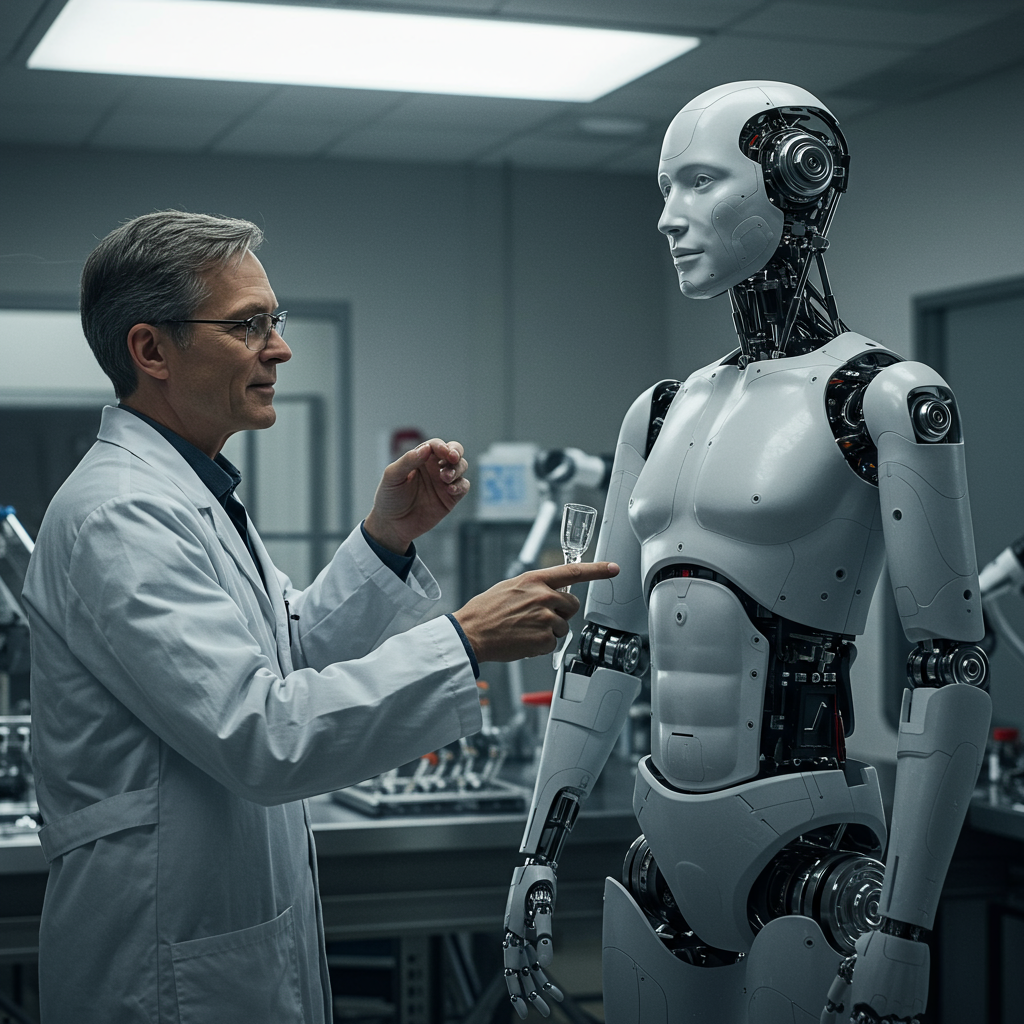

Aber nun zum verbesserungswürdigen, ersten Asimov’schen Gesetz.

Die Historie dazu findet sich auf Wikipedia.

Die drei berühmten Gesetze sind

- Ein Roboter darf kein menschliches Wesen wissentlich verletzen oder durch Untätigkeit wissentlich zulassen, dass einem menschlichen Wesen Schaden zugefügt wird.

- Ein Roboter muss den ihm von einem Menschen gegebenen Befehlen gehorchen – es sei denn, ein solcher Befehl würde mit Regel eins kollidieren.

- Ein Roboter muss seine Existenz beschützen, solange dieser Schutz nicht mit Regel eins oder zwei kollidiert.

Ich habe das entscheidende Wort aus zwei Gründen in Fettschrift gesetzt:

- Im Wikipedia Artikel ist das Wort, ohne weitere Erklärung, in Klammern gesetzt. Im Podcast wurden die Klammern ebenfalls ignoriert.

- Ich sehe hier eine wesentliche Lücke im Schutz der Menschen und im unvorsichtigem Umgang mi KI.

Den zweiten Punkt möchte ich hier weiter ausführen.

Jeder, der sich intensiver mit KI beschäftigt, kennt die mannigfaltigen Aussetzer, die ein Large Language Model haben kann. Vom Erfinden von angeblichen Fakten bis zum kompletten Fehlen einer Antwort ist das Spektrum sehr breit. Auch z.B. Tesla-Fahrer können von „kleinen Ausreissern“ berichten, die von beliebiger Scheibenwischer-Aktivität bis hin zu plötzlichem Eingriff in die Lenkung reichen.

Überträgt man das in Szenarien, in denen humanoide Roboter in von Menschen bewohnten Räumen agieren, macht es einfach keinen Unterschied, ob der Roboter wissentlich oder unwissentlich Menschen verletzt oder tötet.

Mit der Zeit werden die Roboter nicht mehr, wie in aktuellen Videos (immer noch zu großen Teilen ferngesteuert) sehr langsam die ihnen zugedachten Arbeiten verrichten. Mit der Zeit und mit zunehmenden ökonomischen Anforderungen (schneller Job erledigen -> mehr Geld) wird die Arbeitsgeschwindigkeit steigen. Ein „glitch“ beim Ausräumen der Spülmaschine kann dann schon mal einer Person, die sich gerade ein Glas aus dem Schrank neben der Spülmaschine holen möchte, das Leben kosten. Da hilft auch nicht, sich auf den super sicheren Einsatz von Industrierobotern zu beziehen, die 24/7 ohne Aussetzer ihren Dienst verrichten. Diese Roboter sind regelgesteuert und haben mit KI (noch) nichts zu tun. Sie erledigen, im Verhältnis zu humanoiden Robotern im Haushalt, lediglich einen minimalen Bruchteil und sind immer noch meist mühsam in Kleinstarbeit und kleinsten Schritten für ihre Aufgabe vorberietet worden.

Solange KI eine Black Box ist, bei der wir nicht zu einhundert Prozent verstehen, was im Inneren geschieht, sollten wir einfach mit der gebotenen Vorsicht an die Sache herangehen. Das muss keineswegs die Entwicklung einschränken, darf aber Sicherheit von Menschen höher einstufen als pure Gewinnerwartung. Dies entspricht dann sicher dem Geiste der historischen Robotergesetze von Isaac Asimov.

Eine kleine aber nicht unwesentliche Verbesserung des ersten Asimov’schen Gesetzes wäre das endgültige Entfernen des Wörtchens wissentlich aus dem Gesetzestext.